将移动的人真实的穿上合成摇晃的衣服的动作也详细再现

17402024-09-03 16:27:40多货网

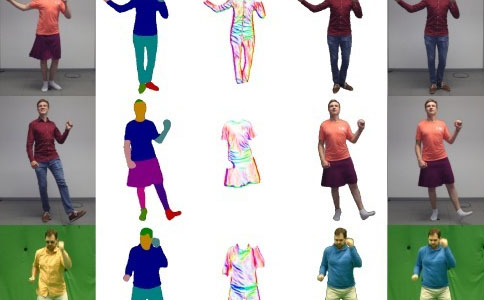

德国布伦瑞克理工学院和德国马克斯普朗克信息学院的研究团队开发的“单目视频的高保真神经人体运动转移”是一种深度学习框架,可以将一个人和衣服的细微运动转移到另一个人身上。这是一个工作。它忠实地再现和合成随着运动而摇摆的衣服的褶皱和褶皱。

该框架旨在仅将源视频中的人的运动转移到目标视频中的人,并针对逼真的动画合成,包括伴随它的衣服的二次运动。视频生成框架使用四种类型的深度学习网络分两个阶段实现。在第一阶段,执行两种类型的网络:一种是从单目摄像头拍摄的视频中估计人的平面形状的网络,另一种是估计服装皱纹和纹理图案的结构的网络,它们是内部的服装的结构。做。此时,根据从视频中获取的人的 2D 骨架姿势预测具有基于像素的标签的每个部分(例如手、脚和头)的前景蒙版。最终输出图像在第二步中使用估计的人的面具和服装结构进行组合。在这里,我们将使用两种类型的网络:一种仅真实合成前景中的人物的网络,以及一种融合了前景和背景场景的最终网络。使用这种方法,可以在短时间内输出高质量的复合视频。尤其是在同一个人将动作转移到不同衣服上的实验中,即使穿着裙子、连衣裙等宽松的衣服,根据人的动作也是真实的。据说即使与目前的类似方法相比,它也被转化为并显示出卓越的品质。

免责声明:将移动的人真实的穿上合成摇晃的衣服的动作也详细再现

内容源于原创或网络以及网友投稿,本站只负责对文章进行整理、排版、编辑,是出于传递更多信息之目的,

并不意味着赞同其观点或证实其内容的真实性,如本站文章和转稿涉及版权等问题,请作者在及时联系本站。本文地址:https://www.veiom.com/article/448.html